Comme je suis un spécialiste de la théorie des probabilités (version courte : un probabiliste), mon expression favorite est « le hasard fait bien les choses ». Je me propose d’en commenter ici deux sens différents à l’aide de concepts probabilistes (plus ou moins) élémentaires.

Le premier sens de mon expression favorite est celui du langage courant : on indique ainsi qu’un évènement heureux, bien qu’inattendu, s’est produit. Mais que signifie-t-on exactement ? A la réflexion, la locution est complexe : les mots « hasard » et « faire » semblent s’opposer, l’un suggérant une absence de volonté et de destin, l’autre sous-entendant une intention : il m’est arrivé quelque chose d’heureux sans que je l’aie provoqué ; c’est le hasard qui en a décidé ainsi. Le hasard apparaît donc comme un dieu bienveillant condamné à faire survenir tout évènement de probabilité non nulle, aussi faible soit-elle – semblable, finalement, au héros tragique selon Jean-Marie Domenach (« Le retour du tragique » Collection Points, Seuil 1967, p. 40) : « concentré sur son objectif, il s’évertue à oublier sa propre histoire, à nier son destin. Mais celui-ci le rattrape, lui rappelle un oubli, une faute, et le rattache à une hérédité, à son corps, à son remords, à son devoir ». La théorie des probabilités nous éclaire-t-elle sur ce dieu étrange ? Non et oui. En aucun cas elle ne peut nous assurer de son existence. Bien que probabiliste, je ne sais pas si le hasard existe ; en d’autres termes, je ne sais pas si Dieu joue aux dés, ou si les lois physiques qui régissent le monde pré-supposent un comportement aléatoire de la matière. Par contre, il est indéniable que certains phénomènes réels (du jeu de dés aux mouvements désordonnés de particules) sont très bien décrits à l’aide des théorèmes issus des axiomes de Kolmogorov, c’est-à-dire de la théorie des probabilités et des statistiques. En particulier, un petit calcul élémentaire montre que n’importe quelle suite finie de piles et de faces apparaît nécessairement au cours d’un nombre infini de lancers répétés indépendamment : le hasard fait donc effectivement bien les choses.

Le second sens de « le hasard fait bien les choses » recouvre une réalité mathématique et numérique : le hasard rend de fabuleux services. Voici un exemple qui est moins stupide qu’il en a l’air. Cherchons à approcher la valeur ½. Un bon moyen consiste à jouer un grand nombre de fois à pile ou face avec une pièce non truquée : le nombre moyen de piles deviendra de plus en plus proche de ½. C’est le principe des méthodes dites de Monte-Carlo, qui consistent à simuler des phénomènes aléatoires sur ordinateur et à moyenner les résultats. Par exemple, on peut ainsi, grâce au jeu très simple appelé « jeu de l’aiguille de Buffon », approcher le nombre pi. Notez que ½ et pi ne sont pas des objets probabilistes mais qu’on peut leur donner des interprétations probabilistes en termes de probabilités d’occurrence d’événements. Ce procédé s’étend à un certain nombre de grandes équations de la physique. A l’aide d’outils mathématiques complexes (le calcul différentiel stochastique, les problèmes de martingales) on peut interpréter de manière probabiliste les équations de Poisson, Navier-Stokes, Burgers, etc. Ceci permet de développer des méthodes de Monte-Carlo qui convergent vers les solutions de ces équations, y compris dans les cas où des méthodes d’approximation numérique plus classiques (c’est-à-dire sans tirages aléatoires) échouent : décidément le hasard fait vraiment bien les choses. Encore mieux, l’intérêt de cette démarche n’est pas purement numérique. De fait, l’interprétation probabiliste d’équations fournit souvent des moyens performants d’analyser mathématiquement ces équations. Ce point est très subtil parce que – sauf pour les probabilistes professionnels, bien entendu – la voie à suivre ne semble pas naturelle du tout. Je vais tenter de présenter simplement un exemple illustre : le calcul de Malliavin (le passage qui suit peut paraître indigeste mais il n’est pas essentiel de comprendre chacun des mots techniques séparément).

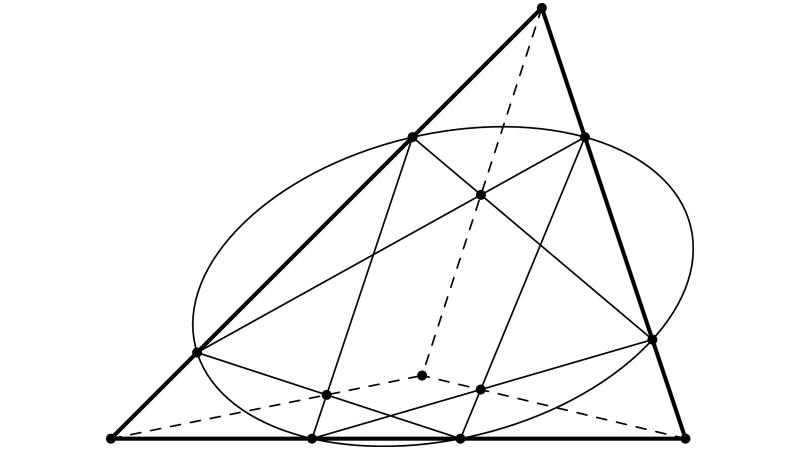

Commençons par quelques mots sur l’équation de la chaleur. Cette « équation aux dérivées partielles parabolique » décrit, pour tout point de l’espace, l’évolution en temps de la température à partir d’une répartition initiale de cette température. Il est bien connu que, même lorsque l’état initial de la température est une fonction très irrégulière (ou même une masse de Dirac, autrement dit une « fonction » qui vaut zéro partout sauf en un point où elle prend une valeur infinie), à tout instant strictement positif la température est une fonction très lisse (plus précisément, infiniment dérivable en temps et en espace) : juste après un Big Bang thermique, c’est l’harmonie céleste. Un magnifique théorème d’analyse, le théorème de Hörmander, montre qu’il en est de même pour des équations bien plus générales que l’équation de la chaleur : les équations aux dérivées partielles paraboliques dirigées par des opérateurs différentiels d’ordre deux dont les coefficients vérifient certaines conditions géométriques appelées conditions d’hypo-ellipticité. A priori, les probabilités n’ont rien à voir avec ce sujet. Pas si sûr. Pour un probabiliste, l’équation de la chaleur décrit l’évolution en temps de la densité de probabilité du mouvement brownien et, plus généralement, une équation parabolique décrit l’évolution en temps de la loi de probabilité d’un objet bien identifié : la solution d’une équation différentielle stochastique. En 1976, Paul Malliavin a développé un calcul des variations stochastiques qui a permis de redémontrer le théorème de Hörmander, et même de l’étendre, en travaillant uniquement sur les propriétés des équations différentielles stochastiques, sans jamais recourir aux équations aux dérivées partielles. La condition géométrique sur les coefficients des opérateurs paraboliques devient, de manière équivalente, une condition d’intégrabilité sur une matrice aléatoire construite à partir des dérivées, au sens des variations stochastiques, des solutions d’équations différentielles stochastiques.

Le calcul de Malliavin a eu beaucoup de développements en analyse stochastique (existence de densités de probabilité pour des processus stochastiques en dimension finie ou infinie, construction d’intégrales stochastiques anticipantes, etc.). De manière vraisemblablement inattendue pour son auteur en 1976, le calcul de Malliavin joue aussi un grand rôle dans l’analyse des méthodes de résolution numérique des équations différentielles stochastiques et dans la construction de techniques améliorant les performances de méthodes de Monte-Carlo : ainsi, des outils sophistiqués d’analyse stochastique aident le hasard à faire encore mieux les choses.

Je termine par une dernière illustration spectaculaire des fabuleux services que rend le hasard : le phénomène de résonance stochastique 2Voir par exemple ici en anglais qu’on rencontre lors de la transmission de signaux ou d’observations du fonctionnement des neurones . En ajoutant un peu de « perturbation » aléatoire à un signal, on peut améliorer la transmission de l’information (par exemple, parce qu’à un niveau de perturbation aléatoire bien choisi, avec de fortes probabilités le signal va passer par certains états souhaitables en des instants multiples d’une période qui représente l’information essentielle du signal). Dans le même ordre d’idées, divers travaux parus dans les années 1980 ont montré qu’ajouter des excitations aléatoires bien choisies permet de stabiliser certains systèmes dynamiques. Décidément, ma maxime favorite est tout sauf hasardeuse !

Un prochain billet sera consacré à l’oxymore « c’est probablement vrai ». Un autre reviendra sur la nature et les objectifs des modélisations probabilistes de phénomènes naturels.