Il y a un an, au cours de l’été 2012, Pierre Colmez avait publié dans « Images des mathématiques » deux billets, titrés respectivement Faut-il arrêter d’enseigner les maths à l’école ? (le 6 août 2012) et Faut-il arrêter d’enseigner les statistiques au lycée ? (le 1er septembre 2012). Les réponses de l’auteur étaient en substance NON à la première question et OUI à la seconde. Dans le second article, l’auteur expliquait que sa motivation pour l’écrire avait été d’expliciter sa pensée sur un passage du premier, que nous reproduisons ici :

Le problème a été grandement amplifié par les diminutions horaires (pour des raisons budgétaires) et l’introduction d’une dose massive de statistiques au lycée. Cette introduction a sûrement été motivée par le rôle grandissant joué par les statistiques dans les sciences expérimentales ou sociales ; l’idée que l’on peut extraire de l’information fiable sans avoir une information complète est une petite révolution intellectuelle qui a amplement prouvé son intérêt pratique. Ceci dit, cette introduction dans un cours de mathématiques, au niveau du lycée, est parfaitement néfaste à plusieurs niveaux. On ne peut pas faire de statistiques sur des objets du cours de mathématiques (on pourrait imaginer faire faire une centaine de lancers de dés à chaque élève pour collecter des données, et glisser 2 ou 3 dés pipés pour pimenter l’expérience, mais on ne va pas aller très loin comme ça). On est donc forcé de faire appel à des données extérieures et donc d’utiliser les statistiques de manière passive, comme une collection de recettes sans vraie signification (la justification mathématique de ces formules est largement au-dessus du niveau du programme), sans s’être demandé ce qu’on voulait mesurer, pourquoi on voulait le mesurer, et comment on devait le mesurer pour ne pas introduire de biais. Cela débouche sur des exercices parfaitement absurdes comme le premier de l’épreuve de Mathématiques du Baccalauréat 2012 de la série ES. La création d’un cours de sciences économiques et sociales comportant une forte composante de statistiques serait sûrement une bonne idée (c’est en gros ce en quoi Hacker 1Professeur de sciences politiques américain auteur d’une tribune dans le New York Times, titrée Is algebra necessary ?, que, en France, Le Monde avait répercutée le 30 juillet 2012, en lui donnant le titre provocateur que Pierre Colmez a repris pour son billet ; mais pour Andrew Hacker la réponse était essentiellement : OUI, il faut arrêter d’enseigner les mathématiques à l’école, du moins en tant que discipline autonome.veut transformer les cours de mathématiques aux États-Unis), mais remplacer des mathématiques proches des sciences exactes par des statistiques revient à privilégier la gestion sur la création.

Ce passage avait provoqué sur « Images des mathématiques » des réactions de désaccord de chacun de nous deux et Pierre Colmez entendait donc y répondre.

Force est de constater que le courrier des lecteurs qui a suivi ce second billet de Pierre Colmez manifestait que sa critique radicale rencontrait un assez large écho. Les opinions exprimées ainsi, rejoignant celles de Pierre Colmez, sont celles que nous avons l’un et l’autre eu maintes occasions de lire ou d’entendre depuis plusieurs années, tant auprès d’enseignants de terrain (où elles s’expliquent largement par la focalisation sur ces « nouveautés » de leur malaise devant la manière dont leur discipline a été « malmenée » depuis de nombreuses années) qu’auprès de responsables ou d’universitaires, chez qui on serait en droit d’attendre plus de recul.

Ces réactions de rejet viennent, et ceci nous paraît très grave, de se manifester dans les projets de programmes de mathématiques mis en consultation, en mai et juin 2013, pour les secondes années des classes préparatoires scientifiques. C’est non seulement la statistique qui y est victime d’ostracisme, car totalement absente, mais aussi le calcul des probabilités qui y est très réduit dans ses ambitions, car le programme dépasse de très peu celui de première année, en passant des variables aléatoires à valeurs dans un espace fini à celles à valeurs dans un espace infini dénombrable (typiquement \(\Bbb N\)) ; on lit explicitement : La notion de variable à densité est hors programme. Si elle se confirmait dans les programmes définitifs (à paraître à l’automne), cette situation contrasterait avec les choix faits pour les programmes des classes terminales des lycées, où figurent les lois normales et (en filière S) les lois exponentielles et où, pour ce qui est de la statistique inférentielle, on initie les élèves aux tests statistiques et aux intervalles de confiance ; elle se démarquerait aussi de ce qui se pratique, au même niveau d’études, dans nombre de sections de techniciens supérieurs ou départements d’IUT2Voir par exemple : J.P. Raoult, L’enseignement des probabilités et de la statistique face à celui des sciences de l’ingénieur en France, à paraître en octobre 2013 dans la deuxième version du numéro spécial évolutif sur le thème de l’interdisciplinarité de la revue Statistique et enseignement. Voir la première version de ce numéro spécial (volume 3, numéro 2) publiée en décembre 2012..

Au moment où divers responsables nous tiennent des discours sur la nécessité de penser un enseignement cohérent de bac-3 à bac+3, ce choix de programme leur donnerait un démenti éclatant dans un des secteurs les plus visibles de l’enseignement supérieur. Une large part de ce que les lycéens auront appris au lycée y resterait inutilisée, et donc probablement vite oubliée, dans les deux années suivantes ; et ceux qui auraient fait le choix de ne pas mobiliser une large partie des connaissances acquises au lycée pourraient en même temps parler de la baisse des connaissances des élèves.

Nous ne nous étendrons pas ici sur les débats relatifs au rôle de la statistique dans la formation du citoyen ou dans la culture générale de l’homme du XXI° siècle, confronté à un matraquage de chiffres, graphiques, tableaux … face auxquels il faut éveiller son esprit critique. La plupart des intervenants dans ces débats en conviennent, mais ils sont nombreux à penser (comme Pierre Colmez) que cette tâche éducative serait, au collège et surtout au lycée, avantageusement exercée par des enseignants d’autres disciplines que les mathématiques (sciences économiques et sociales, sciences de la vie et de la terre, géographie …) 3Quelle(s) discipline(s) devrai(en)t être en charge de l’enseignement de la statistique dans l’enseignement secondaire ? est justement l’une des trois questions mises en débat dans l’éditorial du numéro spécial évolutif sur l’interdisciplinarité (cf. les références du numéro en note 2)..

Nous ne reviendrons pas non plus en détail sur les applications nombreuses du calcul des probabilités, de la statistique inférentielle ou de l’analyse des données à l’ensemble des sciences et des technologies. Là encore nul ne les nie, mais une tendance forte vise à considérer que leur présence dans un cours de mathématiques de lycée ou même, pour une bonne part, de classes préparatoires, serait prématurée, tant en raison de la difficulté des outils mathématiques jugés indispensables pour les traiter « proprement » qu’au motif que les élèves ne seraient pas assez mûrs dans ces domaines d’application pour en tirer tout le bénéfice. Une telle position, s’agissant du rôle de l’aléatoire dans les technologies, semble être aussi celle de la CGE (Conférence des Grandes Ecoles) qui, dans le processus d’élaboration des nouveaux programmes des classes préparatoires, n’aurait pas poussé à l’introduction de plus de stochastique, avec l’argument que les écoles pouvaient enseigner elles-mêmes ce qui, en cette matière, correspondrait à leurs besoins ; est-il exagéré de penser que certains ne seraient pas très heureux si l’arrivée de nouveaux étudiants mieux formés à l’aléatoire les forçait à revoir les cours habituellement donnés dans les écoles ?

Implicitement, dans toutes ces positions, on voit à la fois l’idée qu’il s’agit d’apprentissages empiriques, et donc (Pierre Colmez le dit explicitement) sans portée mathématique, et la conviction que charger de ces apprentissages d’autres enseignants que ceux de mathématiques (comme on l’a fait par exemple jadis d’enseignements de mécanique) permettrait de gagner de l’espace pour recentrer le cours de mathématiques vers des « fondements » actuellement sacrifiés.

Ce sont ces idées que nous voudrions contrer ici, en plaidant pour le caractère intrinsèque aux mathématiques des probabilités et d’une bonne part de la statistique, et donc pour l’apport que peut en retirer l’enseignement des mathématiques dans son intégralité. 4Nous ne sommes heureusement pas isolés dans l’expression de cette conviction. Parmi de nombreuses initiatives récentes, citons par exemple l’ouvrage de Jérôme Depauw, Statistiques (Vuibert, juin 2012), accessible aux enseignants de mathématiques, dans la préface (par Yves Derriennic) duquel on lit : Dans le livre qu’il propose aux étudiants de master 1 de mathématiques, Jérôme Depauw porte un regard neuf sur quelques questions bien choisies de la statistique mathématique. Sans renier les origines concrètes de ces questions, bien illustrées par des exercices numériques à traiter avec le logiciel R, il montre, dans un style acéré, comment les matières du programme de licence, algèbre linéaire, calcul différentiel et intégral, analyse complexe, probabilités, sont nécessaires à la justification rigoureuse des règles de calcul statistique, même les plus courantes. Car la statistique, contrairement à l’image qu’on en donne trop souvent, offre comme l’analyse ou la géométrie, l’occasion de jolies démonstrations et de raisonnements inventifs..

Cette place de ces disciplines au sein de l’édifice mathématique est de plus en plus reconnue par les chercheurs ; pourquoi donc la retombée de cette conviction sur la pratique enseignante rencontre-t-elle tant d’obstacles en France ? Et pour ceux qui objectent le manque d’attractivité de ces branches de programmes, telles qu’ils les voient en œuvre dans les collèges et lycées aujourd’hui, nous voudrions les persuader que, au contraire, nombre d’élèves peuvent être stimulés par le fait qu’on peut leur présenter là des mathématiques « en action », avec des possibilités de traitement réfléchi de données réelles (et non « de manière passive » comme semble le juger inévitable Pierre Colmez. Encore faudrait-il que les programmes soient largement repensés et les enseignants mieux aidés ; nous y reviendrons.

Pour voir que des applications concrètes peuvent motiver des élèves à étudier et comprendre des structures abstraites, il suffit de regarder un exemple dont on parle peu : la spécialité, en classe terminale de la filière ES, traitant de théorie des graphes a été un succès, au point qu’elle est maintenant aussi au programme de la filière S ; elle amène les élèves, entre autres choses, à étudier des questions non triviales d’algèbre linéaire en dimension finie quelconque qui avaient depuis longtemps disparu du lycée.

Précisons que les points d’ancrage que nous allons détailler maintenant n’ont aucune ambition à constituer des contre-propositions de programmes ; il s’agit de manifester la richesse de potentialités dont nous trouvons navrant qu’elles ne soient pas exploitées et, chemin faisant, de mettre en évidence quelques points qui nous paraissent incontournables. Il ne nous parait pas non plus indispensable que ces possibilités figurent (notamment en classes préparatoires) dans des chapitres de programme identifiés comme « probabilités » ou « statistique » ; il peut y avoir profit à les associer directement aux chapitres de mathématiques qu’elles peuvent mettre en valeur.

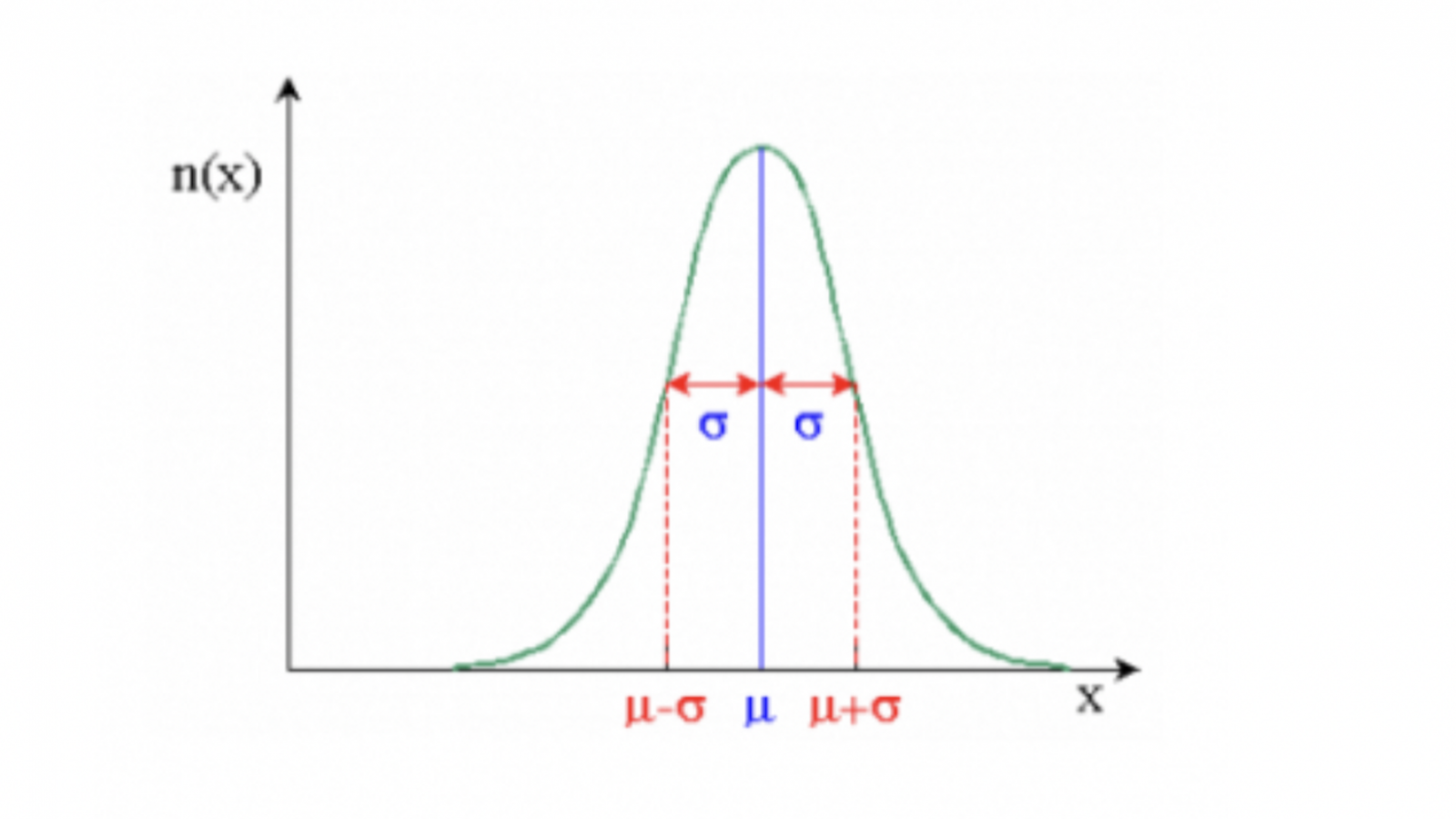

Un des arguments souvent avancés dans ce débat est qu’une priorité actuelle pour l’enseignement des mathématiques dans ce pays est de redonner une place aux structures fondamentales de l’algèbre et de la géométrie ; or si ces fondations ont été sacrifiées, c’est en grande partie parce que la période des « maths modernes » les avaient maladroitement disconnectées de justifications qui, à l’époque, pouvaient se trouver en particulier dans les liens avec la physique ; et c’est ainsi que, progressivement, on en est venu à ne plus enseigner le barycentre et le moment d’inertie ; or il s’agit très exactement, en statistique empirique (ou pour des probabilités sur ensemble fini de valeurs réelles), des moyennes et des variances. Il y a donc là du beau travail à faire, en modulant selon les niveaux, sur les structures linéaires et quadratiques, la statistique jouant pour le cours de mathématiques le rôle de muse pour laquelle la physique est, aujourd’hui défaillante 5Il y a lieu ici de déplorer les évolutions récentes des programmes de physique de lycée, qui s’éloignent de plus en plus d’un appui sur les outils mathématiques, au profit d’une « culture générale » en physique qui nous paraît souvent superficielle ; sur un point comme celui que nous venons d’évoquer, comme sur d’autres (par exemple les calculs d’erreurs), il y aurait tout à gagner pour le cours de mathématiques à pouvoir travailler en parallèle sur les aspects physiques et les aspects probabilistes ou statistiques.. Il n’est jusqu’aux considérations très élémentaires, dès le niveau du collège, sur moyenne et médiane qui ne puissent être reliées à des mises en évidence des structures impliquées dans chacune : numérique dans un cas, mais simplement ordre total dans un autre, ce qui permet de « dédiaboliser » les gênes dues à la non unicité dans la définition de la médiane (ou des quantiles).

Mais c’est principalement par leurs liens avec le cours d’analyse que le calcul des probabilités et la statistique peuvent le plus contribuer à vivifier l’enseignement des mathématiques. Et on se trouve là en France devant une situation paradoxale et, espérons-nous, temporaire. D’une part, en classes terminales des lycées, alors que les outils d’étude des fonctions et d’intégration sont présentés avec pas mal de lacunes et d’incohérences, la loi normale y est centrale et y permet en particulier d’aboutir, en statistique inférentielle, à une présentation des intervalles de confiance asymptotiques conforme à la pratique des statisticiens ; en effet le passage des intervalles de fluctuation aux intervalles de confiance, qui a troublé nombre d’enseignants, repose sur des raisonnements d’inversion de fonctions continues qui sont bien à la portée de ces enseignants (on ne le leur sans doute pas encore assez montré) mais dont le programme ne donne pas les moyens aux élèves 6Sans parler des occasions, fort utiles pour la culture mathématique, d’usage du graphisme. C’est ainsi que l’un d’entre nous (J.P. Raoult) n’avait aucun mal il y a cinquante ans à faire assimiler à ses étudiants la dualité entre intervalles de fluctuation (I.F., on ne disait pas ainsi alors, mais peu importe) et intervalles de confiance (I.C.) car ces derniers s’obtenaient, pour les statisticiens (ou usagers de la statistique) professionnels à l’aide d’abaques où les I.F. se lisaient en sections verticales et les I.C. en sections horizontales ; il a été frappé l’an dernier par la surprise émerveillée, devant ces objets venus du passé, chez des professeurs de lycées pour qui le passage des I.F. aux I.C. n’était que calculatoire et donc mal maîtrisé.. Mais d’autre part, en classes préparatoires scientifiques, où les nouveaux programmes de première année (entrés en vigueur en 2013) mettent bien en place les outils de calcul différentiel et intégral trop peu stabilisés au lycée, on envisage de refuser tout usage de ces outils en calcul des probabilités, à en juger par les projets actuels de programmes de seconde année (MP, PC, PSI … à appliquer en 2014) puisque les densités de probabilités y sont hors programme.

Le seul lien entre analyse et probabilités exploité dans ces projets de programmes repose sur les séries numériques, puisque l’on y traite les variables aléatoires à valeurs dans \(\Bbb N\) (notamment celles de Poisson) ; or ce lien aurait pu être activé dès la première année, puisque les séries numériques y sont maintenant au programme, et un exercice classique comme la limite de \((1-a/n)^n\) y trouverait une illustration non triviale. Mais c’est bien sûr surtout le calcul intégral qui peut prendre vie avec les exercices sur les lois à densités, tant sur leurs fonctions de répartition que sur leurs moments7Voir un catalogue d’exemples dans : P. Arnoux, Quelques exercices d’analyse en théorie élémentaire des probabilités, ; il est intéressant de voir là aussi bien de nombreux cas de calculs classiques que de vastes possibilités d’exploitation de simulations numériques, qui sont bien dans l’esprit des programmes ; au-delà des visualisations de la loi des grands nombres ou du théorème central limite, il est par exemple assez fascinant de voir l’absence d’espérance mathématique de la loi de Cauchy se traduire dans le comportement erratique de ses simulations.

Le niveau des classes préparatoires devrait se prêter aussi – et on est bien là au cœur des mathématiques – à la réflexion sur la qualité des approximations et donc sur la vitesse de convergence dans les théorèmes asymptotiques qui les justifient ; c’est ainsi que l’on peut éclairer les contraintes classiquement placées sur l’approximation normale de la loi binomiale de paramètres \(n\) et \(p\), du type : «\(np(1-p)\) pas trop petit» ; le rôle central de ce \(np(1-p)\) apparaît à la fois dans les simulations numériques et dans la démonstration «historique» à l’aide de la formule de Stirling (un joyau de l’analyse classique élémentaire dont les élèves verraient là un bel usage). C’est là la raison principale pour laquelle il nous paraît inconcevable que l’on ne se donne pas le moyen de traiter la loi normale, sur laquelle ces élèves de classes préparatoires vont rester sur les idées assez vagues recueillies en terminale (où on ne savait pas définir son espérance mathématique) – ou les oublier -, alors que cette loi de probabilités est constamment évoquée hors du champ mathématique. Ce serait plus formateur et motivant que de multiplier des exercices de limites, de calcul d’intégrales dont les étudiants ne voient pas d’applications.

Il serait capital aussi, nous semble-t-il, que figure dans la culture des futurs scientifiques (ou utilisateurs de moyens scientifiques) l’idée fondamentale que les mathématiques appliquées conduisent souvent à considérer des exigences contradictoires entre lesquelles il faut arbitrer ; dans les simulations numériques, c’est l’opposition entre coût et précision ; la statistique inférentielle en fournit de nombreux exemples : contradiction entre précision de l’intervalle de confiance et niveau de confiance, équilibre à trouver entre les erreurs de première et seconde espèces pour les tests statistiques ; dans tous ces cas il s’agit de maximiser des fonctions sous contraintes, démarche fondamentale de l’analyse pour laquelle il est profitable de donner aux étudiants des exemples convaincants et réalisables. Seule la prise de conscience de ces tensions permet d’éviter le reproche souvent fait de « recettes » à l’égard de l’usage de ces outils dans l’enseignement.

Il y a peut-être plus grave dans cet état de choses : les mathématiques qu’ils ont apprises en « prépas » sont, pour bon nombre de cadres scientifiques et techniques en France, l’archétype du fondement mathématique de la culture scientifique utile ; c’est ainsi qu’y ont droit de cité, par exemple, les séries de Fourier ou les équations différentielles, qui prolongent naturellement le cours sur les fondements de calcul différentiel et intégral. En éliminer tout un pan central du calcul des probabilités et la totalité de la statistique entretient chez ces cadres une connaissance insuffisante de la prise en compte du hasard qui est très dommageable.

Revenons aux réticences des enseignants de mathématiques en France devant l’enseignement du calcul des probabilités et, surtout, de la statistique.

Elles relèvent grandement d’un souhait, relayé par Pierre Colmez dans ses articles cités en préambule, d’un « recentrement » des programmes sur les fondements des mathématiques, qui finit par évoquer pour nous l’image mélancolique d’immenses et inaltérables fondations pour un harmonieux édifice qui ne sera jamais construit, car ceux qui pourraient le faire refusent de bâtir plus haut que le niveau du sol pendant que d’autres, ailleurs, construisent des baraquements disjoints qui seront les seuls à servir… ; il n’est pas sûr que les mathématiques et leur enseignement en sortent grandis.

Mais ces réticences des professeurs sont aussi largement justifiées car il faut reconnaître que, à cet égard, on ne leur a pas facilité la vie ! il ne s’agit pas pour nous ici de demandes « quantitatives » au profit des probabilités et de la statistique ; le drame est que jusqu’ici on a beaucoup raisonné en « poids » des enseignements, en opposant les secteurs des mathématiques les uns aux autres ; il est essentiel ici non d’enseigner « plus » mais d’enseigner « mieux » et ceci passe en particulier, au lycée, par une amélioration sensible des programmes d’analyse qui, s’agissant des limites, des fonctions, de l’intégration font des impasses souvent peu justifiables (même en termes de gain de temps) et pesants sur les possibilités en probabilités 8Voir : J.P. Raoult, Les nouveaux programmes de probabilités et statistique : cohérence et incohérences, conférence à l’IREM de Reims, 16 mai 2012 .. Il importe aussi, notamment dans les classes préparatoires, d’impliquer autant que possible ces enseignements au sein même du cursus mathématique. Mais tout ceci exige d’accompagner ces évolutions par une volonté résolue de fournir aux enseignants les moyens (documents, stages …) de s’y adapter, de réfléchir dessus et, espérons-nous, d’en apprécier le bien-fondé.

15h16

Voir les 5 commentaires