Le projet d’automatiser le calcul des traductions est un projet ancien, formulé dès la fin des années 40 par le mathématicien américain Warren Weaver, qui propose de voir dans un texte en langue source (par exemple en russe) la version cryptée d’un document en langue cible (par exemple en anglais) et d’envisager la traduction sous l’angle du décodage d’un message secret 1“One naturally wonders if the problem of translation could conceivably be treated as a problem in cryptography. When I look at an article in Russian, I say `This is really written in English, but it has been coded in some strange symbols. I will now proceed to decode.’” (Weaver, 1949).

Une première question essentielle concerne la représentation du texte source : est-il suffisant de le traiter comme une suite de caractères ou de mots ? Ou bien doit-on d’abord en dériver une représentation abstraite, par exemple logique, qui en représentera le sens profond ? Cette seconde solution a longtemps été privilégiée, l’hypothèse étant que disposer de représentations plus « abstraites » facilitera la génération d’un message cible à la fois syntaxiquement correct et sémantiquement équivalent au message original. Cette approche a permis des avancées considérables dans l’élaboration de modèles symboliques (logico-déductifs) manipulant des structures discrètes combinatoires afin de construire une représentation formelle du sens de tout énoncé. Elle se heurte toutefois au besoin de disposer de descriptions extrêmement fines des contrastes linguistiques, qui sont difficiles et coûteuses à construire et qui peinent à capturer la variabilité intrinsèque et les évolutions des langues. Les mêmes difficultés de modélisation se posent pour élaborer des mécanismes de génération de textes en langue cible.

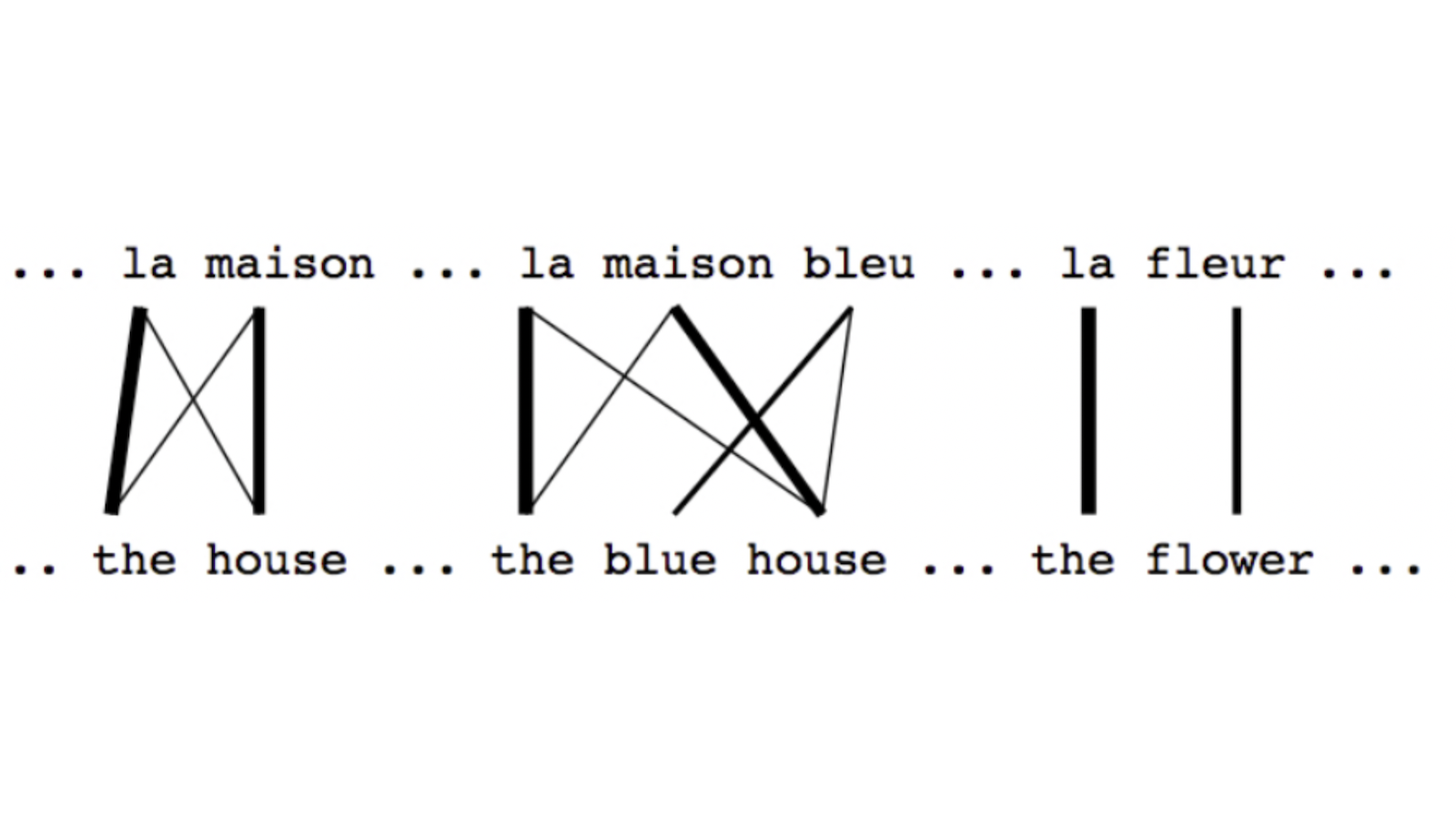

L’alternative, qui triomphe aujourd’hui, voit la traduction comme l’application d’une fonction paramétrique appariant directement un message source avec sa traduction. L’utilisation de méthodes d’apprentissage automatique appliquées à des millions de traductions humaines permet de régler automatiquement les paramètres de la fonction reproduisant au mieux les exemples fournis au système. La mise en œuvre de telles approches s’appuie massivement sur les outils des mathématiques appliquées : estimation de modèles stochastiques, optimisation numérique de fonctions continues, etc. Ce changement de formalisme ne règle toutefois pas complètement la question des représentations les plus adaptées à ce type d’apprentissage, suscitant de nombreux travaux visant à apprendre des fonctions entre ensembles de structures combinatoires – appariant par exemple des arbres syntaxique (en langue source) à des séquences de mots (en langue cible). Les modèles statistiques les plus récents, fondés sur des réseaux de neurones artificiels, éludent cette difficulté et permettent d’apprendre y compris les représentations optimales des textes source et cible, sous la forme de séquences de vecteurs numériques en grande dimension.

Si les outils mathématiques ont bien changé depuis les premiers pas de la traduction automatique, depuis l’utilisation de modèles algébriques jusqu’aux techniques d’optimisation qui sont au cœur des traducteurs statistiques, la modélisation mathématique continue donc de fournir des outils essentiels pour améliorer la qualité des traductions automatiques.

Post-scriptum

Ce texte appartient au dossier thématique « Mathématiques et langages ».

Article édité par Jérôme Germoni.

Il est possible d’utiliser des commandes LaTeX pour rédiger des commentaires — mais nous ne recommandons pas d’en abuser ! Les formules mathématiques doivent être composées avec les balises .

Par exemple, on pourra écrire que sont les deux solutions complexes de l’équation .

Si vous souhaitez ajouter une figure ou déposer un fichier ou pour toute autre question, merci de vous adresser au secrétariat.